Как правильно настроить Robots.txt

В 2019 году телеканал HBO потерял важные позиции в поисковике из-за ошибки в файле robots.txt. Из-за неправильных настроек поисковики не смогли индексировать страницы сайта. Это казус стал уроком для многих, но правильно настроенный файл может стать вашим помощником в SEO.

В этом руководстве мы расскажем, как создать и настроить файл robots.txt, чтобы он работал на вас и не мешал индексации.

Что такое robots.txt

Robots.txt — текстовый файл, который размещается в корневой папке сайта. Он даёт указания поисковым системам: какие страницы индексировать, а какие не трогать.

Схематично работа файла выглядит — без него поисковики не найдут нужную строчку, страницу или контент

Файл выполняет три основные функции:

- Управляет индексацией. Robots.txt скрывает служебные страницы, которые не нужны пользователям, например, корзины покупок, личные кабинеты или черновики. В поисковой выдаче будут только важные разделы сайта.

- Снижает нагрузки на сервер. Директива Crawl-delay ограничивает частоту запросов поисковых роботов, что особенно важно для крупных сайтов.

- Устраняет дубли. Файл закрывает страницы с одинаковым содержимым, но разными URL-параметрами. Это положительно влияет на SEO-показатели.

Когда Googlebot, YandexBot, заходят на ресурс, они первым делом обращаются к нему. В этом документе указывается, какие документы разрешено обходить, а какие следует пропустить. К примеру, директива Disallow: /manager/ ограничивает доступ к разделу /manager/. Ведущие поисковики Google и Яндекс, следуют инструкциям, но некоторые сканирующие системы могут их игнорировать.

Если есть папка /docs/ с внутренними документами, её можно закрыть с помощью директивы Disallow, поисковики не будут её обходить.

Чем robots.txt отличается от других способов управления индексацией

Robots.txt — один из инструментов управления видимостью, но не единственный. Есть еще два популярных метода:

- Мета-тег robots.

Этот тег добавляется в HTML-код страницы и управляет индексацией только для нее. Например, noindex скрывает конкретную страницу от поисковиков, не затрагивая другие. - X-Robots-Tag.

Это HTTP-заголовок, задающий настройки индексации на уровне сервера. Он удобен для управления файлами, такими как PDF или изображения, куда нельзя добавить мета-тег.

Пример: чтобы скрыть PDF-документ, используется X-Robots-Tag с параметром noindex. Это решение не требует изменения содержимого файла.

Как создать файл robots.txt

Для этого подойдёт любой текстовый редактор (тот же Notepad). Главное — сохранить его с расширением .txt и загрузить в корневую папку сайта.

Основные команды, которые вам понадобятся:

- User-agent: указывает, для какого робота действуют правила.

- Disallow: ограничивает доступ к разделам сайта.

- Allow: разрешает доступ к определённой странице. Представим, вы закрыли доступ ко всем страницам в разделе /private/, но хотите, чтобы одна конкретная страница была доступна, используйте команду Allow: /private/open-page.html.

- Crawl-delay: задаёт паузу между запросами. Так, Crawl-delay: 10 ставит паузу в 10 секунд между запросами, чтобы не перегружать сервер.

Для корректной работы важно соблюдать синтаксис. Каждое правило начинается с директивы User-agent, за которой идут Disallow, Allow и другие команды. Все команды пишутся строчными буквами, значения указываются без пробелов.

Где разместить файл и как проверить его работоспособность

Файл должен быть в корневой папке сайта, рядом с главной страницей. Если файл находится не там, поисковые роботы его не найдут.

Для каждого поддомена нужно создать отдельный файл robots.txt и разместить его в корневой папке этого поддомена.

Как проверить, что файл доступен:

- Откройте файл через браузер. Если он открылся, значит, всё в порядке.

-

Используйте инструменты проверки:

- Google Search Console — раздел «Настройки» поможет проверить, как Googlebot видит ваш файл и правильно ли он работает.

- Яндекс.Вебмастер — в панели Яндекса есть аналогичная проверка, чтобы убедиться, что поисковики следуют заданным правилам.

Можно ещё использовать Robots.txt Checker. Он проверит на доступность, синтаксис и посмотрит, какие документы открыты или закрыты для индексации.

Ошибки, которые часто встречаются в файле robots.txt

Ошибки в настройке могут повлиять на индексацию. Вот самые распространённые:

- Неправильное размещение файла: если файл не в корне сайта, поисковики не смогут его найти.

- Ошибки синтаксиса: отсутствие слэша в директиве Disallow, лишние пробелы или неправильные команды могут сделать файл бесполезным.

- Чрезмерные ограничения: например, если вы случайно укажете Disallow: /, это закроет весь сайт от индексации.

- Не закрытые важные страницы: если забыли закрыть административные панели или другие конфиденциальные разделы, они могут попасть в поисковик.

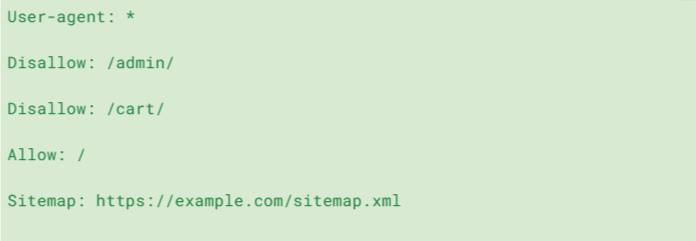

Для наглядности — вот так выглядит правильный файл:

Он блокирует доступ к административной панели и корзине, но оставляет возможность индексировать другие страницы сайта. Этот пример показывает, как можно точно настроить видимость различных разделов.

Что ещё может robots.txt

Файл robots.txt — это не только способ скрыть страницы от индексации. Он также позволяет настроить дополнительные параметры, которые помогают поисковикам работать быстрее и точнее. Вот как можно использовать расширенные возможности:

Указание карты сайта

Директива Sitemap подскажет роботам, что в приоритете одни страницы, а другие не стоят внимания. Такое полезно, когда у вас большой сайт, например, агрегатор банковских услуг или медицинских центров по всей стране. Если карта не одна, то не стесняйтесь в файле прописать их все.

Оптимизация URL и устранение дублей

Директива Clean-param помогает Яндексу избавиться от дублирующего контента. Если на сайте есть страницы с одинаковым контентом, но разными параметрами в URL, например ?sort=asc или ?page=2, Clean-param сообщает Яндексу, что эти параметры не важны.

Clean-param: sort, page

Clean-param поддерживается только Яндексом. Для Google управление параметрами можно настроить в Google Search Console.

Это важно, чтобы избежать появления дублей в поисковой выдаче и улучшить SEO. Указывая параметры, которые не влияют на содержание страницы, вы помогаете поисковикам не тратить ресурсы на лишние запросы.

Устаревшая директива Host

Ранее директива Host использовалась для указания Яндексу основного домена, если у сайта было несколько версий, например, example.ru и example.com. Сейчас Яндекс сам определяет основной домен, поэтому директива Host больше не нужна.

Использование этой директивы — прошлое. Яндекс давно перешёл к автоматическому определению главного домена, поэтому от неё можно смело отказаться.

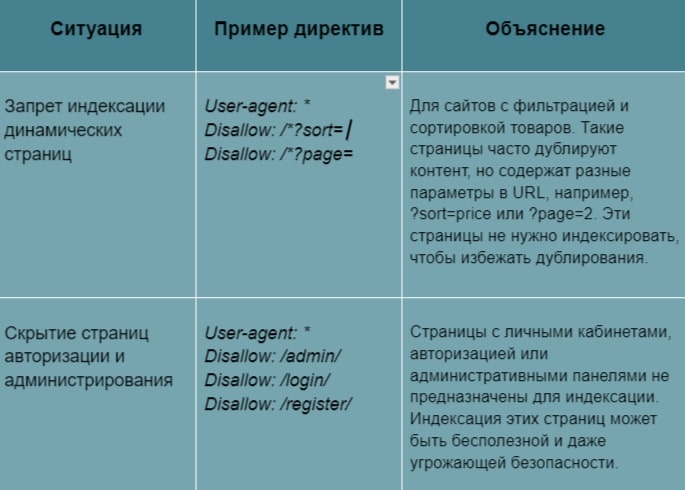

Вот ещё примеры использования robots.txt:

Советы от опытных сеошников

Работа с файлом robots.txt — это не разовое действие, а постоянный процесс, требующий внимания и регулярных корректировок. Чтобы обеспечить эффективную индексацию и избежать ошибок, влияющих на SEO, следуйте этим практическим рекомендациям.

- Регулярная проверка и обновление файла

Сайт постоянно меняется: появляются новые страницы, разделы и функционал. Если файл не обновлять, поисковики могут начать индексировать нежелательные страницы или пропустить важные.

Что делать?

- Периодически проверяйте файл и убедитесь, что директивы актуальны.

- Добавляйте новые разделы в файл, если они не должны индексироваться.

- Удаляйте устаревшие директивы, чтобы не создавать путаницу.

- Тестирование изменений

Перед внесением изменений важно убедиться, что они не приведут к ошибкам, таким как закрытие всего сайта от индексации.

Как это сделать?

- Используйте тестовую среду для проверки изменений.

- Пользуйтесь Google Search Console и Вебмастером.

Проверяйте ключевые страницы, чтобы убедиться, что нужные разделы открыты для индексации.

- Совмещение с другими инструментами SEO

Robots.txt нужен для управления индексацией, но один он «не вывезет» весь трафик: представьте, сколько конкурентов и постоянно появляющихся сайтов надо затмить? Поэтому лучше совмещать несколько методов.

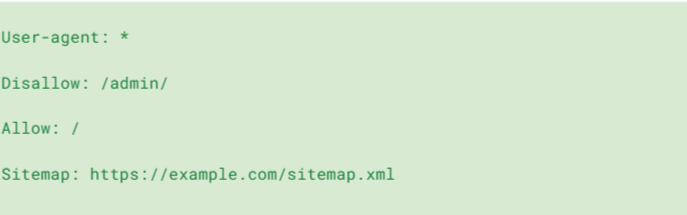

Помимо нашего файла, внедрите мета-тег , чтобы закрыть от лишних глаз ненужные страницы. А если, наоборот, требуется показать какой-то важный раздел, то укажите ссылку на карту сайта в файле «робота».Как это может выглядеть:

- Защита конфиденциальных данных

Не полагайтесь только на robots.txt для защиты данных. Используйте аутентификацию и другие средства безопасности.

- Следите за обновлениями поисковых систем

Требования поисковых систем могут меняться. Используйте инструменты вебмастеров для отслеживания индексации и своевременного реагирования на изменения.

Вопросы и ответы

Нужен ли файл robots.txt для небольших сайтов?

Да, он необходим. Даже на небольших сайтах бывают страницы, которые не стоит показывать в поисковой выдаче — например, страницы авторизации или корзины. Для этого используется файл robots.txt.

Как часто нужно обновлять robots.txt?

Обновлять файл нужно всякий раз, когда меняется структура сайта. Это могут быть добавление новых разделов, изменение URL или удаление устаревших страниц. Периодически проверяйте файл раз в пару месяцев, чтобы всё было актуально.

Что делать, если поисковые роботы не следуют инструкциям в robots.txt?

Проверьте синтаксис файла с помощью Google Search Console или Яндекс.Вебмастер. Эти инструменты покажут, есть ли ошибки. Если изменения были внесены недавно, подождите пару дней, чтобы поисковая система обновила данные, или запросите повторное сканирование. Для более надёжной защиты конфиденциальных страниц используйте пароли или настройте ограничения доступа на сервере.

Что нужно учитывать при работе с robots.txt?

Файл robots.txt помогает управлять видимостью страниц, но важно помнить, что это всего лишь рекомендация для ботов, и не все роботы ей следуют. Для дополнительной защиты используйте пароли и настройки сервера.

Если у вас остались вопросы по настройке или вы хотите убедиться, что файл работает правильно, мы поможем. Наша команда проведет анализ вашего сайта, настроит robots.txt и оптимизирует его для максимальной эффективности. Мы не только обеспечим индексацию нужных страниц, но и защитим проект от лишнего трафика и рисков.

Обратитесь к нам, и мы поможем сделать ваш сайт видимым, безопасным и эффективным для поисковых систем. А если хочется узнать нас получше, подписывайтесь на ТГ-канал Дмитрия Дементьева — генерального директора Cinar. Больше пользы по продвижению и маркетингу в бесплатном канале «Разумное продвижение с Cinar».

Наш блог c полезными советами

13.01.2026

Как оплатить ChatGPT в России в 2026 году?

13.01.2026

Как оплатить ChatGPT в России в 2026 году?

21.10.2025

Когда бизнесом управляют цифры: зачем считать коэффициент сезонности

21.10.2025

Когда бизнесом управляют цифры: зачем считать коэффициент сезонности

21.10.2025

Google Trends: как анализировать популярные запросы для бизнеса

21.10.2025

Google Trends: как анализировать популярные запросы для бизнеса

21.10.2025

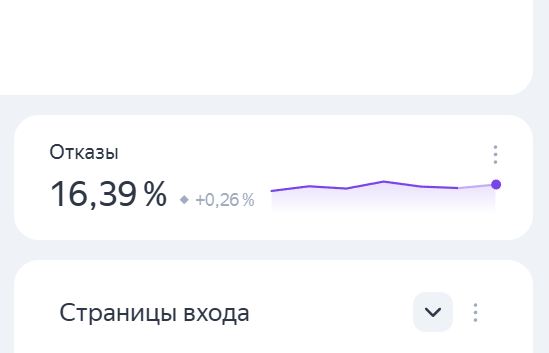

Как снизить показатель отказов на сайте и улучшить поведение пользователей

21.10.2025

Как снизить показатель отказов на сайте и улучшить поведение пользователей

19.06.2025

Что такое GSC и зачем он нужен 3

19.06.2025

Что такое GSC и зачем он нужен 3

18.06.2025

Контент-план без суеты: как упорядочить идеи и не утонуть в хаосе

18.06.2025

Контент-план без суеты: как упорядочить идеи и не утонуть в хаосе